|

|

H I P E R P R Z E S T R Z E Ń- elegancja w wyższych wymiarach |

Elegancja teorii fizycznych i odpowiadających im równań matematycznych, to przede wszystkim zwięzłe, oszczędne ale jednocześnie pełne i ścisłe zdefiniowanie jak największego zakresu zjawisk fizycznych. W życiu codziennym podobne wymagania mamy w stosunku do gier: dobra gra powinna posiadać proste ale ścisłe reguły i jednocześnie charakteryzować się dużą ilością wariantów (jak np. w szachach: 10134 !).

Ideałem byłoby tutaj zawarcie samej istoty materii i energii oraz czasu i przestrzeni w jednym równaniu, z którego można by wyprowadzić wszystkie inne prawa fizyki czy też np. określić charakterystyki cząstek elementarnych, wartości stałych uniwersalnych itp.

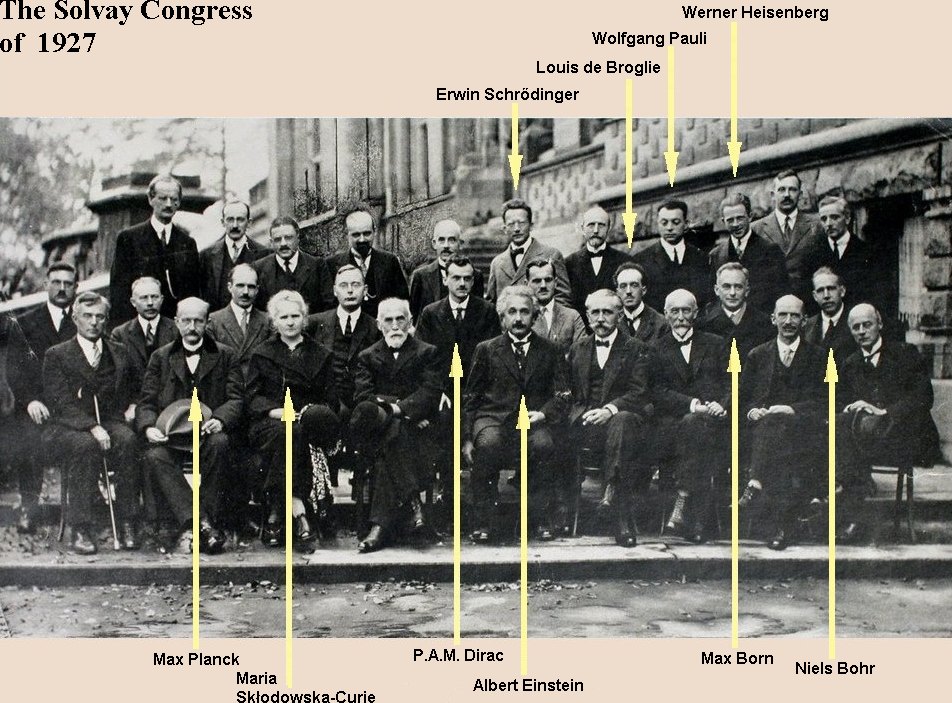

Od dziesiątków już lat prace gigantów fizyki, zmierzające do odkrycia takiej Uniwersalnej Teorii Świata, skupiają się na unifikacji czterech fundamentalnych sił przyrody, na pierwszy rzut oka wydających się zupełnie odmiennymi: oddziaływań elektromagnetycznych, silnych i słabych oddziaływań jądrowych oraz oddziaływań grawitacyjnych. Bez stworzenia Jednolitej Teorii Pola, teorii, która wyjaśni naturę i pochodzenie wszystkich znanych sił przyrody nie można mówić o zrozumieniu podstawowej natury materii.

Isaac Newton (1642 - 1727)

|

|

Prawo grawitacji Newtona:  gdzie: G - stała grawitacyjna: G = 6,672 . 10-11Nm2/kg2 Wzór ten jest dla nas oczywisty: siła jest proporcjonalna do każdej z oddziaływujących mas i odwrotnie proporcjonalna do kwadratu odległości między nimi.

|

Równanie grawitacji jest jasne i proste, ale nie oznacza to wcale, że nie ma problemów z rozwiązywaniem zagadnień z tego zakresu. Dotychczas nie udało się znaleźć ogólnego wzoru pozwalającego na obliczenie ruchu trzech ciał wzajemnie oddziaływujących grawitacyjnie (nie mówiąc o większej liczbie obiektów). Trochę więcej o tym, a także demonstrację ruchu obiektów w polu grawitacyjnym, można znaleźć w części dotyczącej DHTML.

W XVIII wieku podobny matematyczny zapis sił działających pomiędzy ładunkami elektrycznymi oraz magnetycznymi (traktowano wtedy te oddziaływania jako całkowicie niezależne od siebie) wprowadził Charles Coulomb.

Georg Bernhard Riemann (1826 - 1866) |

Gdyby teraz były rozprawy habilitacyjne takiego formatu, Uniwersalna Teoria byłaby chyba już opracowana.

James Clerk Maxwell (1831 - 1879) |

|

Równania Maxwella ( przyjmujemy c = 1 )  |

Gdy Albert Einstein, korzystając z nadmiaru wolnego czasu podczas pracy w urzędzie patentowym w Bernie, uważnie przeanalizował równania Maxwella, sformułował w 1905r. podstawę szczególnej teorii względności: prędkość światła jest taka sama we wszystkich poruszających się układach. Doprowadziło to do przyjęcia czasu jako czwartego wymiaru, a w konsekwencji do unifikacji wszystkich wielkości fizycznych mierzonych w przestrzeni i czasie, takich jak materia i energia. Znalazł w ten sposób precyzyjne matematyczne wyrażenie na jedność materii i energii: E = mc2, będące chyba najsłynniejszym równaniem fizyki.

Albert Einstein (1879 - 1955) fot. z 1905r. |

, zestaw równań pola elektromagnetycznego można zapisać jednym równaniem:

, zestaw równań pola elektromagnetycznego można zapisać jednym równaniem:

|

Następne lata upływają Einsteinowi na poszukiwaniu teorii grawitacji (czyli dotyczącej nieinercjalnych układów, w których na ciała działają siły grawitacyjne) zgodnej ze szczególną teorią względności. Formułuje podstawową zasadę: obecność materio-energii określa zakrzywienie czasoprzestrzeni, która ją otacza. Brakuje mu jednak odpowiedniego aparatu matematycznego, który pozwoliłby na opracowanie pełnego formalizmu teorii.

Dopiero w 1915r., gdy jego przyjaciel, matematyk Marcel Grossman, natknął się w bibliotece na prace Riemanna sprzed sześćdziesięciu lat, okazało się, że jest to dokładnie to, o co chodziło. Prawie cały słynny wykład Riemanna z 1854r. znalazł swoje odbicie w teorii Einsteina, a sam tensor metryczny okazał się zapisem pola grawitacji. Można powiedzieć, że cały matematyczny opis teorii pola grawitacyjnego (zakrzywienia czasoprzestrzeni) stworzył Riemann. Zabrakło tu jednak fizycznej interpretacji równań, a przede wszystkim idei, że to materio-energia określa zakrzywienie przestrzeni.

Wróćmy tu jeszcze do prac Riemanna. Po pierwszych latach fascynacji teorią wielowymiarowych przestrzeni, w późniejszym okresie, aż do 1905 roku, stała się ona domeną tylko czystej matematyki. Nikt w tym okresie nie próbował wykorzystać jej zgodnie z ideą, którą kierował się Riemann: użycie zakrzywionej hiperprzestrzeni do wyjaśnienia natury "sił przyrody".

Koncepcje wyższych wymiarów miały w historii zawsze swoich przeciwników. Ich argumenty najczęściej sprowadzały się do stwierdzenia, że "czwarty wymiar nie istnieje, ponieważ nie można go sobie wyobrazić".

Niektórzy udowadniali trójwymiarowość przestrzeni na podstawie przesłanek fizycznych: gdyby przestrzeń była czterowymiarowa, to oddziaływania (np. światło, grawitacja) malałyby wraz z sześcianem odległości. Takiego argumentu użył m.in. w 1917r. fizyk Paul Ehrenfest, nota bene przyjaciel Einsteina, w artykule "W jaki sposób w fundamentalnych prawach fizyki przejawia się trójwymiarowość przestrzeni?".

Argument ten można zakwestionować przynajmniej w niektórych wypadkach: dla przestrzeni silnie zakrzywionych w którymś z wymiarów.

Wyobraźmy sobie w płaskim dwuwymiarowym świecie punktowy ładunek wytwarzający typowe pole (np. elektryczne). Natężenie pola będzie malało proporcjonalnie do odległości od ładunku: "powierzchnią" otaczającą ładunek będzie w tym wypadku obwód okręgu rosnący proporcjonalnie do odległości.

Jeśli nasza "dwuwymiarowa przestrzeń" ulegnie

Podobna sytuacja byłaby w czterowymiarowym świecie, gdyby jeden z wymiarów uległ "zwinięciu": pole rozchodziłoby się tak, jak w zwykłej trójwymiarowej przestrzeni.

Po sukcesach szczególnej i ogólnej teorii względności, Einstein podejmuje znowu próbę stworzenia kolejnej wielkiej teorii - zunifikowanej teorii pola. Na bezskutecznych poszukiwaniach tej "teorii wszystkiego", która wyjaśni naturę wszystkich znanych sił przyrody, włącznie ze światłem i grawitacją, Einsteinowi upływa ostatnie 30 lat życia.

Gdy Einstein rozpoczynał te prace, zagadnienie dotyczyło tylko dwóch znanych wówczas sił: elektromagnetycznych (tzn. praktycznie siły Coulomba) i grawitacyjnych. Obydwie siły są oddziaływaniami dalekiego zasięgu, typu 1/R2. Mała wartość stałej powszechnego ciążenia powoduje, że oddziaływania grawitacyjne są znikomo małe w porównaniu z siłami Coulomba. Siła przyciągającego oddziaływania elektrycznego między protonem i elektronem jest ok. 1039 razy większa od oddziaływania grawitacyjnego między nimi. Podnosząc ze stołu skrawki papieru naelektryzowanym grzebieniem widzimy, że pole elektryczne wytworzone przez ten maleńki przedmiot jest silniejsze od pola grawitacyjnego całej Ziemi.

Richard Feynman w swoich "Wykładach" podaje przykład, także bardzo sugestywnie przemawiający do wyobraźni.

Gdyby jedna osoba stanęła w odległości ramienia od drugiej osoby i jeśliby każda z tych osób miała o jeden procent więcej elektronów niż protonów, to siła odpychająca między tymi osobami byłaby dostatecznie wielka, aby unieść ciężar równy "ciężarowi" całej Ziemi.

Oddziaływania grawitacyjne są tak słabe, że można by pomyśleć, że są to tylko szczątkowe, wypadkowe siły elektryczne, wynikające z nierównomiernego rozmieszczenia ładunków elektrycznych w ciałach materialnych (wzajemne polaryzowanie się obiektów). Podobnie jak siły międzycząsteczkowe w równaniu gazu van der Waalsa.

Przykładowo, neutron jest cząstką elektrycznie obojętną i między dwoma neutronami nie powinno występować oddziaływanie elektryczne. Wg obecnych teorii cząstka ta składa się z trzech kwarków o ładunkach elektrycznych (w jednostkach elementarnego ładunku): +2/3, -1/3, -1/3. Gdy przyjmiemy układ dwóch neutronów tak, jak na rysunku, to wypadkowa siła oddziaływania elektrycznego, wynikająca z minimalnych różnic w odległościach między kwarkami, będzie przyciągająca.

Taki układ można sobie narysować dla kilku cząstek, ale co zrobić ze wszystkimi we Wszechświecie ?

Poza rzędem wielkości obydwu sił, podstawowa różnica między tymi oddziaływaniami to fakt, że siła ciężkości jest zawsze przyciągająca a siły elektryczne mogą być i przyciągające i odpychające. Jednokierunkowość sił (jak w grawitacji) jest podstawową cechą równań ogólnej teorii względności, co znacznie utrudnia "wmontowanie" do nich sił elektromagnetycznych.

Theodor Kaluza (1885 - 1954) |

Blok gij jest starą czterowymiarową metryką Einsteina, gdzie w każdym punkcie przestrzeni jest zdefiniowany zbiór dziesięciu liczb (gij = gji). Piąty wiersz i piątą kolumnę identyfikuje się z polem Maxwella, dla którego w każdym punkcie przestrzeni jest zdefiniowany zbiór czterech liczb: składowe 4-potencjału pola elektromagnetycznego (jeden nie zaznaczony składnik to cząstka skalarna, nie mająca tutaj znaczenia).

Oskar Klein (1894 - 1977) |

Powyższa teoria, zwana tradycyjnie teorią Kaluzy-Kleina, już w latach trzydziestych została praktycznie zaniechana. Poza brakiem możliwości udowodnienia istnienia piątego wymiaru, powodem było pojawienie się nowej teorii, która zrewolucjonizowała świat fizyki.

Teorią tą była mechanika kwantowa.

W przeciwieństwie do gładkiej, geometrycznej interpretacji pola sił, stworzonej przez Einsteina, w teorii tej wszystkie siły powstają dzięki wymianie dyskretnych porcji energii, zwanych kwantami.

Werner Heisenberg (1901 - 1976) i Niels Bohr (1885 - 1962) |

Można sobie wyobrazić, jak fizycy pracowicie spędzają dziesiątki lat na manipulowaniu wartościami wszystkich tych 19 parametrów w celu ich optymalnego "dostrojenia". Kojarzy mi się to z dziedziną bardzo od fizyki odległą: polityką. Poszczególne ugrupowania przelicytowują się pomysłami na korygowanie w różnych kierunkach dziesiątków, dotyczących oczywiście głównie pieniędzy, wskaźników (stawek podatków, obowiązkowych ubezpieczeń, ulg, dotacji, koncesji itd.). Może to być niekończący się proces, bo żadne (powiedzmy: prawie żadne) z tych ugrupowań nie ma wizji zerwania z tym "brzydkim" modelem ręcznego sterowania i stworzenia "eleganckiego", samoregulującego się modelu, o prostych i jasnych regułach i ograniczonej do całkowicie niezbędnego minimum liczbie takich sztucznie wprowadzanych parametrów.

Peter van Nieuwenhuizen (ur. 1938) fot. z 1993r. |

Po kilku dziesiątkach lat sukcesów mechaniki kwantowej i modelu standardowego, już z końcem lat sześćdziesiątych nadzieje na rozwiązanie tą drogą problemu Wielkiej Unifikacji i Teorii Wszystkiego zaczęły przygasać. Przypomniano sobie wtedy o starej teorii Kaluzy-Kleina i zaczęto wracać do idei wyższych wymiarów.

Od czasów opracowania tej teorii fizyka wzbogaciła się o znajomość świata mikrocząstek z jego symetriami i polem Yanga-Millsa. Ale, gdy pół wieku wcześniej przed fizykami stało zadanie zjednoczenia tylko dwóch oddziaływań: grawitacji i elektromagnetyzmu, teraz doszły silne i słabe oddziaływania jądrowe. Było jasne, że trzeba tu będzie więcej, niż pięciu wymiarów.

Z tych prób wykorzystania idei Kaluzy-Kleina wyłoniła się teoria supergrawitacji, przedstawiona w 1976r. przez trzech fizyków z Uniwersytetu w Stony Brook: Daniela Freedmana, Sergio Ferrarę i Petera van Nieuwenhuizena. Teoria ta już po dalszych udoskonaleniach, opierała się na jedenastowymiarowej czasoprzestrzeni. Sformułowanie superteorii Kaluzy-Kleina w 11 wymiarach wymagało znacznego zwiększenia ilości składników w tensorze Riemanna, który w ten sposób stał się supertensorem Riemanna. Łączył on teraz w sobie zarówno oddziaływania (grawitacyjne, elektromagnetyczne, jądrowe) jak i materię:

Ta superunifikacja wszystkich sił i cząstek Wszechświata wywołała ogromny oddźwięk w świecie fizyki. Jeden z jej twórców, Peter van Nieuwehuizen, napisał, że supergrawitacja "może zjednoczyć wielkie zunifikowane teorie (...) z grawitacją, tworząc model który niemal nie ma swobodnych parametrów. Jest to unikalna teoria (...) tak piękna, że Natura powinna być jej świadoma". Stephen Hawking, gdy w kwietniu 1980r. obejmował w Cambridge profesurę Lucasa (stanowisko to niegdyś zajmował Isaac Newton), wygłosił wykład pod optymistycznym tytułem "Czy widać już koniec fizyki teoretycznej?".

W latach osiemdziesiątych zaczęto jednak dostrzegać problemy związane z supergrawitacją. W żadnym z eksperymentów nie wykryto tzw. s-cząstek, których istnienie przewidywała teoria. Stało się też jasne, że teorii tej nie da się poprawnie skwantować (teoria nie poddaje się renormalizacji, czyli nie można pozbyć się nieskończoności powstających przy uwzględnianiu poprawek kwantowych). Te i inne problemy sprawiły, że zainteresowanie fizyków zaczęło się kierować w stronę innej teorii: chyba najdziwniejszej, ale i najpotężniejszej, jaka kiedykolwiek została zaproponowana.

Ta nowa teoria to teoria superstrun.

Jej historia zaczęła się jeszcze w 1968r., gdy młodzi fizycy z CERN-u w Genewie, Gabriel Veneziano i Mahiko Suzuki, poszukując funkcji matematycznych, które mogłyby opisać zachowanie silnie oddziaływujących cząstek, natknęli się niezależnie od siebie na funkcję beta, stworzoną w XIXw. przez Leonharda Eulera. Zaskoczyło ich, że funkcja ta ma prawie wszystkie własności niezbędne do opisania oddziaływania silnego cząstek elementarnych. W 1970r. Yoichiro Nambu z Uniwersytetu w Chicago i Tetsuo Goto z Uniwersytetu w Nihon wykazali, że za cudownymi własnościami funkcji beta kryje się drgająca struna.

Po kilku latach intensywnych prac nad modelem Veneziano-Suzuki'ego, w 1974r. badania uległy gwałtownemu zahamowaniu. Okazało się, że teoria ta jest spójna tylko w dziesięciu oraz w dwudziestu sześciu wymiarach, a prawie nikt nie wierzył by teoria zdefiniowana w takiej hiperprzestrzeni miała coś wspólnego z rzeczywistością.

Przez całe dziesięciolecie, od 1974 do 1984r., teoria pozostawała w zapomnieniu. Był to okres powrotu do teorii Kaluzy-Kleina oraz popularności modelu supergrawitacji.

Edward Witten (ur. 1951) |

Michio Kaku (ur. 1947) |

|

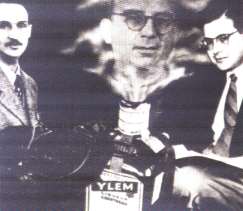

George Gamow jako dżin wyłania się z butelki z "ylemem", hipotetyczną pierwotną materią, z której powstał Wszechświat w Wielkim Wybuchu. Po lewej Ralph Alpher. Obdarzony poczuciem humoru Gamow namówił fizyka jądrowego Hansa Bethego (zm. 6.03.2005r. w wieku 98 lat), aby dodał on swoje nazwisko do listy autorów, dzięki czemu ich teorię nazywa się modelem "alfa-beta-gamma". |

Bóg stwarzający Wszechświat Wiliam Blake, 1757-1827 |

Należy sobie uświadomić, że utrwalone w naszej świadomości wyobrażenia o materii są nieco złudne. Wyobrażenia te oparte są na naszych zmysłach wzroku i dotyku. Przedmioty, które widzimy dookoła, wydają nam się ściśle wypełnione materią. W rzeczywistości ta materia to niemal pusta przestrzeń.

Obszar, w którym elektrony krążą wokół jadra atomowego, jest więcej niż 10 tysięcy razy większy od objętości zajmowanej przez jądro. Odległość między atomami metalu w krysztale jest rzędu 10-8 cm, natomiast rozmiar nukleonu to ok. 10-13 cm.

To elektrony powodują, częściowe lub całkowite, odbijanie kwantów światła (fotonów) przez przedmiot materialny i dlatego ten przedmiot możemy oglądać. Patrząc na błyszczący biały metal (srebro, aluminium) możemy powiedzieć, że "widzimy" swobodne elektrony; gaz swobodnych elektronów w tym metalu nie pozwala na przeniknięcie do środka fal świetlnych.

Siły elektrostatycznego odpychania pomiędzy elektronami w powierzchniowych warstwach dwóch przedmiotów nie pozwolą także na "przeniknięcie" jednego przedmiotu przez drugi.

W świecie fizyki tak już jest, że wraz ze zmniejszaniem się obiektów gwałtownie wzrastają siły działające na te obiekty, od bardzo słabych sił grawitacyjnych oddziaływujących we wszechświecie do krańcowo potężnych sił wiążących ze sobą kwarki w nukleonach. Te ostatnie siły są tak wielkie, że dotychczas nie wykryto eksperymentalnie kwarków jako cząstek swobodnych. Gdyby te cząstki miałyby się składać z kolejnych mniejszych elementów, to, można przypuszczać, występowałby tam nowy rodzaj sił jeszcze potężniejszych.

Mechanika kwantowa z modelem standardowym, mimo niezaprzeczalnych osiągnięć (także w życiu codziennym: jej efektem są m.in. diody i tranzystory), jak już powiedziano, nie jest ostateczną teorią materii. Nie obejmuje ona grawitacji a jej zgodność z danymi doświadczalnymi okupiona została dopasowanymi (nie wynikającymi z teorii) parametrami. Nie jest to absolutnie elegancka teoria, czego należałoby oczekiwać od Uniwersalnej Teorii.

Kontrowersyjna też jest jedna z podstawowych tez tej teorii: zasada nieoznaczoności.

Zasada ta, odrzucając w istocie przyczynowość w pewnych obszarach świata fizycznego, podważa fundamenty, na których opiera się nasze poznanie świata. Przeczy ona w pewnym sensie tezie, że w całej przyrodzie obowiązują znane nam lub nieznane, ale ścisłe prawa.

Generalnie, wydają się prawdopodobne dwa główne "scenariusze" podstawowej istoty materii:

Być może kluczem do stworzenia ostatecznej teorii są wielowymiarowe przestrzenie i właśnie teoria superstrun? Może właśnie geometria miniaturowej, około stu miliardów miliardów razy mniejszej od protonu, struny odpowiedzialna jest zarówno za pochodzenie sił jak i za strukturę materii?

Jak widzieliśmy, w wyższych wymiarach zagadnienia się upraszczają a teorie zyskują na elegancji, obejmując swym zasięgiem większy zakres zjawisk.

Słabym punktem teorii superstrun jest to, że nie potrafimy jej w chwili obecnej w żaden sposób udowodnić (tak samo, jak żadnej teorii zdefiniowanej przy energii Plancka wynoszącej 1019 miliardów elektronowoltów). Kontrowersje wzbudza zwłaszcza przestrzeń o dodatkowych, zwiniętych, wymiarach. Czy rzeczywiście świat posiada więcej niż trzy wymiary przestrzenne, a jeżeli tak, to dlaczego niektóre uległy zwinięciu?

|

| /rysunek pochodzi z "Ilustrowanej krótkiej historii czasu" Stephena Hawkinga, wyd. polskie ZYSK i S-KA, 1996r./ |

Teoria superstrun to bardzo zaawansowany matematycznie model. Niektórzy z matematyków stwierdzili, że może należałoby ją traktować jako gałąź matematyki, bez względu na to, czy ma jakieś fizyczne znaczenie.

Istotne przede wszystkim jest, aby opracowany model był doskonale zgodny z fizyczną rzeczywistością we wszystkich jej przejawach. Być może, że teoria superstrun będzie takim modelem. I być może, że wtedy na pytanie, z czego zbudowana jest ta mała struna, w czym rozchodzą się te drgania będące cząstkami elementarnymi, będziemy mogli tylko odpowiedzieć, że tym tworzywem jest eter ...

Aby nie ulec pochopnej fascynacji teorią superstrun i światami wielowymiarowymi trzeba jednak spojrzeć na tę teorię także krytycznie.

Sceptyk może uważać, że to tylko matematyczna żonglerka z wykorzystaniem wyimaginowanego obiektu o bardzo szerokim spektrum możliwych zachowań (drgająca struna, a w nowszej teorii membrana) w tak dobranym n-wymiarowym świecie, aby matematyczny zapis własności tego obiektu można było dostosować do opisu pewnej grupy zjawisk fizycznych.

Może to być sytuacja podobna, jak w poniższym przykładzie.

Próbujemy dopasować krzywą, o możliwie prostym równaniu, do danych punktów.

Przy dwóch punktach, naturalnym podejściem jest przyjęcie prostej o jakimś równaniu

Przy dwóch punktach, naturalnym podejściem jest przyjęcie prostej o jakimś równaniu

Jeśli następne pojawiające się punkty nie będą zgadzały się z naszym równaniem, przypuszczalnie będziemy zwiększać jego stopień i przy sześciu punktach, tak rozmieszczonych jak na rysunku, otrzymamy mało eleganckie równanie

Jeśli następne pojawiające się punkty nie będą zgadzały się z naszym równaniem, przypuszczalnie będziemy zwiększać jego stopień i przy sześciu punktach, tak rozmieszczonych jak na rysunku, otrzymamy mało eleganckie równanie

y = 0,01x5 + 0,01x4 - 0,35x3 - 0,01x2 + 0,98x - 5

już z sześcioma parametrami.

W tym momencie - mając na uwadze prostotę równania - możemy mieć wątpliwości, czy jesteśmy na dobrej drodze.

I zupełnie słusznie, gdyż punkty należą do spirali Archimedesa o bardzo prostym równaniu

I zupełnie słusznie, gdyż punkty należą do spirali Archimedesa o bardzo prostym równaniu

Sceptyk może właśnie kwestionować elegancję teorii superstrun - dodatkowe wymiary, ich promienie zwinięcia to przecież wprowadzane dodatkowe parametry ( stałe przyrody ). Może rozwiązanie jest prostsze, lecz polega na czymś innym?

Powyższy przykład oczywiście odnosi się też, i to w większym stopniu, do mechaniki kwantowej. Jak pamiętamy, w modelu standardowym mamy aż 19 wprowadzonych sztucznie parametrów.

Paradoksalne jest to, że im bardziej podstawowe i fundamentalne aspekty materii są badane, tym bardziej abstrakcyjne stają się rozważania nad nimi! Jeden z największych matematyków w XIX wieku, Alferd North Whitehead, powiedział, że matematyka na swoim najgłębszym poziomie jest nierozdzielna z fizyką na jej najgłębszym poziomie.

|

"Hic sunt leones" (łac.: tu przebywają lwy) - na dawnych mapach tak oznaczano kraje nieznane ("białe plamy") |

|

Inspiracją do napisania artykułu była książka Michio Kaku "Hiperprzestrzeń" (wyd. polskie Prószyński i S-ka, 1999r.).

|